¿Qué es KG4LLM?

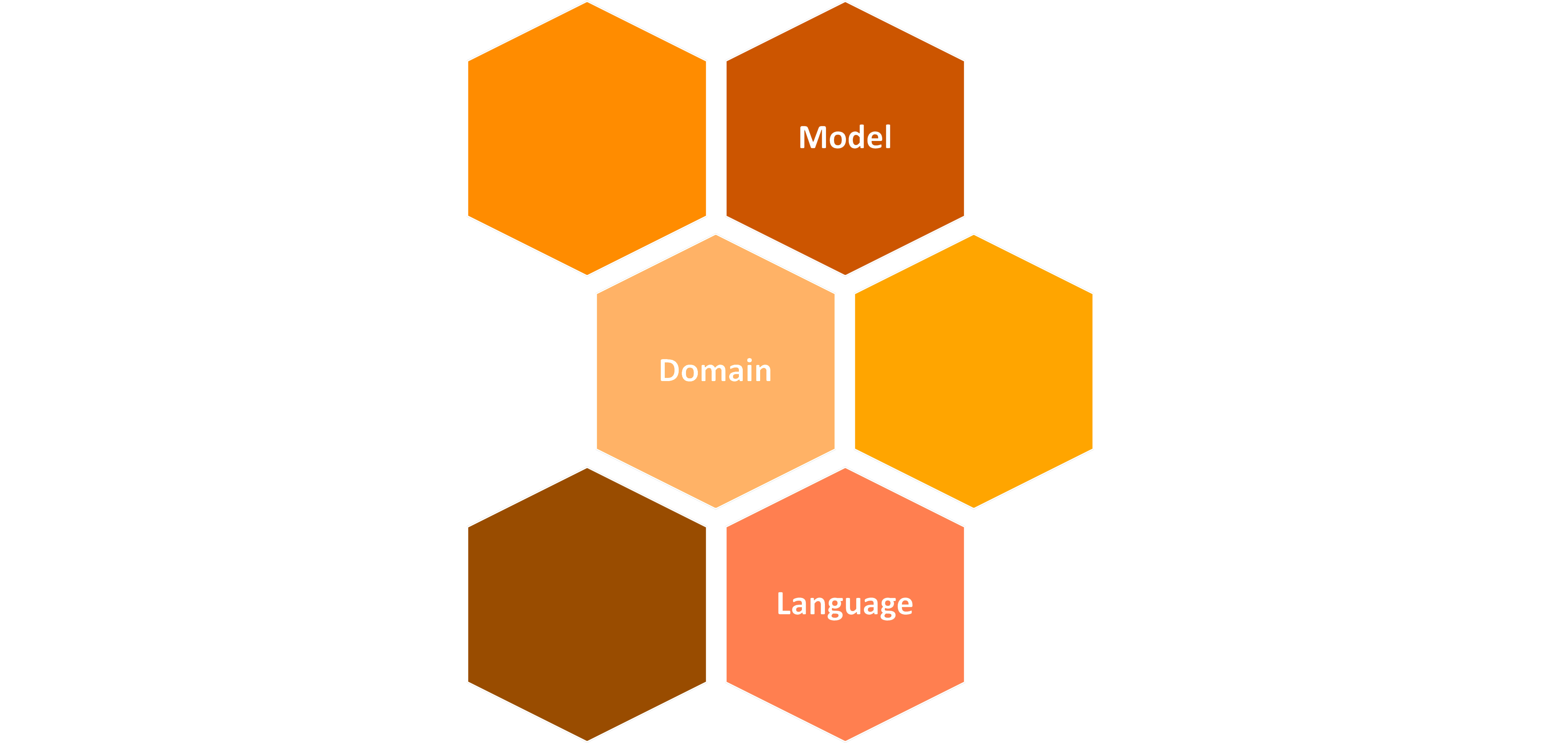

Investigar, desarrollar y demostrar métodos de integración y enriquecimiento de LLM mediante la inyección de conocimiento estructurado procedente de Grafos de Conocimiento y el acceso a servicios de razonamiento simbólico y de recuperación de información, con el fin último de solucionar las barreras existentes que entorpecen la adopción generalizada de LLM, entre las que destacan problemas de factualidad, sesgo, confiabilidad, adaptabilidad a dominios específicos, tamaño de los modelos y soporte de lenguas adicionales, en particular el español y lenguas cooficiales.

Multilingüismo y adaptación a dominio

El objetivo del proyecto es la adaptación e inyección de conocimiento de dominio a LLMs en los cuatro idiomas cooficiales del Estado español (castellano, euskera, catalán y gallego).

Para elegir en qué dominios verticales se realizará dicha inyección, se llevó a cabo un estudio siguiendo varios criterios en cuanto a disponibilidad de recursos lingüísticos para dichos dominios: corpora textual, bases de datos de verificación con datos factuales, recursos semánticos estructurados y conjuntos de datos de evaluación

Siguiendo estos criterios, se eligieron los siguientes dominios: Salud, Legal, Patentes y Seguros.

Evaluación y mejora de la factualidad

Proponemos un marco general para la evaluación de factualidad con cuatro fases fundamentales, cada una de las cuales evaluarán la factualidad del modelo en un ámbito diferente y complementario

Nuestro objetivo es aumentar el porcentaje de hechos correctos en el texto generado por el modelo para los pares de dominio e idioma objetivo y disminuir la proporción de hechos incorrectos. Nuestra propuesta se basa en el algoritmo de DPO para alinear un LLM dado con un objetivo de factualidad, apoyándonos en estimadores basados en confianza y referencias (cuando sea posible) para generar un dataset de preferencias de manera agnóstica del dominio y del idioma.

Consideramos el uso de plantillas de modelos basados en conocimiento, como las empleadas para tareas de diagnóstico o evaluación para guiar el razonamiento del LLM de manera estructurada. Para ello, seguiremos un enfoque de problem-solving prompting (PSP), además de seguir el enfoque por SELF-RAG para gestionar la información recuperada durante el prompting.

Evaluación y mejora del sesgo

Proponemos cinco métodos presentes en la literatura para la evaluación del sesgo en los LLMs, basados tanto en técnicas de análisis de embeddings como estudios probabilísticos: DisCo, CrowS-Pairs Score, Co-Ocurrence Bias Score, Toxic Fraction y HONEST .

Los métodos de mejora de la factualidad presumiblemente convertirán al LLM en un modelo más robusto y menos sesgado, pero también planteamos mejorar las salidas generadas por los modelos y mitigar los sesgos mediante técnicas de intra-procesamiento, como la modificación de estrategias de decodificación de los modelos, y técnicas de post-procesamiento, como la reescritura del resultado con la sustitución de palabras discriminatorias.

Uso de herramientas externas

En esta tarea se va a entrenar un LLM para que use, cuando sea necesario, una herramienta de búsqueda construida sobre Wikipedia en español y las lenguas cooficiales. Se usará DPO para que el LLM aprenda a preferir generar texto con llamadas a la herramienta búsqueda cuando sea necesario y viceversa.

Esta experimentación nos permitirá entender si con un enfoque de aprendizaje de preferencias es posible aprender a usar herramientas externas. Además, se pretende calcular qué numero de ejemplos es necesario para que el LLM aprenda a usar las herramientas y si usar DPO tiene ventajas sobre el enfoque de Toolformer, por ejemplo, requiriendo un menor número de ejemplos necesario para entrenar el sistema.

Generación de grafos de conocimiento

Para la tarea de construcción de grafos de conocimiento partir de textos usando modelos generativos se va a usar un enfoque de secuencia de estructura linealizada, en el que utiliza el conocimiento estructural y la semántica de las etiquetas para generar un formato de salida unificado.

El formato de salida puede ser una representación intermedia a partir de la cualse derive el grafo de conocimiento o incluso la representación final del grafo de conocimiento en un formato determinado.

Entregables

Puede descargar a continuación los entregables del proyecto:

Documento del estado de la cuestión, guías para la inyección de conocimiento en LLM y métricas.

Métodos de inyección de conocimiento en LLM.

Métodos de inyección de conocimiento en LLM.

Métodos de uso de herramientas externas por LLM.

Métodos de uso de herramientas externas por LLM.

Análisis y definición de dominios de aplicación y casos de uso.

LLM adaptados a dominio.

Métodos de extracción de grafos de conocimiento a partir de texto mediante LLM.

Marco de evaluación y recursos asociados.

Diseño del demostrador.

Web del proyecto.

Plan de trabajo y plan de calidad.